Процедура измерения предопределяет его результат. Все академические дисциплины располагаются где-то в спектре между теми, в которых существует общий консенсус по поводу правомочности хотя бы некоторых способов измерения, и теми, в которых он отсутствует. В первых ученые считают, что полученные определенными методам данные отражают истинное положение вещей, и — пока наука находится в куновской нормальной фазе — сразу переходят к анализу полученных результатов. Во вторых главным поводом для дискуссий становятся не результаты, а процедуры их получения, поскольку ни одна из них не принимается всеми как достаточно надежная. В первых ученые преимущественно спорят о фактах, во вторых — о способах производства этих фактов. Наукометрия принадлежит ко второй группе. Каждый конкретный случай вычисления показателей цитирования сразу вызывает вопросы о том, почему был использован именно такой алгоритм подсчета, а не один из множества других, в равной мере убедительных (или, скорее, в равной мере неубедительных), некоторые из которых привели бы к совершенно другим выводам. Поскольку никаких окончательных рациональных аргументов в пользу одного из методов не может быть приведено, дебаты регулярно устремляются в русло поиска скрытых политических мотивов.

Те, кто обнаружил, что связался с вечно сомневающейся дисциплиной наподобие наукометрии, и не готов посвятить себя чистой эпистемологии ради нее самой, могут повести себя одним из трех путей — разумным, честным или практичным. Разумный путь состоит в том, чтобы вовсе бросить это занятие. Честный — в том, чтобы, продолжая вычислять что-то, предупреждать свою аудиторию обо всех сделанных ходах и показывать, что было бы, если бы был избран другой путь, предоставляя читателям делать выводы самостоятельно. Практичный -в том, чтобы найти слушателей, которые хотят поверить в определенный результат, и, когда кто-то объявит им, что все именно так и обстоит, не будут слишком настойчиво требовать, чтобы им объяснили, как именно был получен этот вывод. Раз уж выбор методов все равно является политическим, то и действовать надлежит политически, производя данные, которые усиливают риторические позиции своей партии и ослабляют позиции противоположной.

Исследование эффективности финансирования российской науки, проведенное Александром Варшавским и Валентиной Маркусовой (B&M), показывает, что такое политическая наукометрия в действии. Она получило широкую известность и стало аргументом в публичных дебатах [1], несмотря на то, что лишь очень небольшой круг людей может похвастаться тем, что видел полный отчет о нем. Фактически единственный опубликованный текст по мотивам этого исследования [2] не содержит большей части существенных в таком деле процедурных деталей и, если углубиться в него, полон необъяснимого. Но его целевая аудитория вовсе и не была намерена в него углубляться. Отчет говорил именно то, что эта аудитория желала услышать и доказать другим: российская наука, и в особенности Академия, здорова и сохраняет конкурентоспособность; фактически она остается лучшей в мире; все ее трудности объясняются недостатком финансирования; при условии увеличения бюджетных ассигнований прочие неприятности могут быть поправлены несколькими внутренними циркулярами, требующими обязательно упоминать РАН в англоязычных публикациях и чаще цитировать своих российских коллег.

Я хотел в этой статье шаг за шагом проследить, как именно авторам удалось прийти именно к такому выводу, несмотря на ощутимое сопротивление материала, и как они могли бы получить при желании прямо противоположный результат.

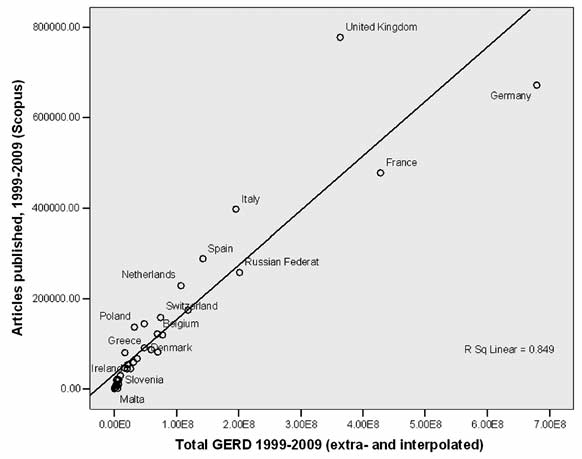

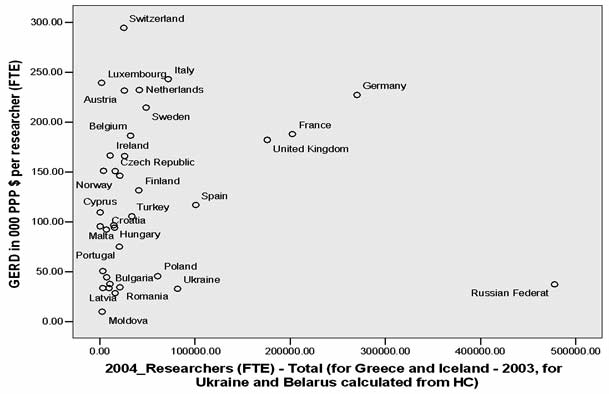

Рис. 1 представляет соотношение объема финансирования НИОКР в европейских странах в 1999-2009 гг. и число англоязычных статей, написанных учеными из них, в базе Scopus за тот же период [3]. Вообще говоря, он не содержит никаких поразительных откровений: страны выстраиваются более-менее по диагонали, указывающей на почти линейную связь между объемом финансирования и публикационной продуктивностью. Чем больше денег вложено, тем «видимее» национальная наука интернационально. При ближайшем рассмотрении, однако, выясняются некоторые дополнительные нюансы. Таблица 1 указывает «цену» статьи в тысячах евро. Россия оказывается на пятом месте, уступая только Люксембургу (расчеты для которого как для мини-государства в центре Шенгенской зоны в высшей степени проблематичны), Германии, Франции и Австрии и превосходя большую часть постсоциалистических стран в два и более раза. Общий объем финансирования можно представить как произведение двух переменных: числа исследователей и экономического обеспечения каждого из них. Рис. 2 показывает распределение стран в этом пространстве. Большая часть кажутся вытянутыми в одну линию вдоль левого края рисунка от наименее (Молдова, Латвия, Румыния) до наиболее (Швейцария, Италия, Люксембург) щедро, в пересчете на одного ученого, финансируемых. Основных отклонений в сторону большей численности четыре — богатые и многочисленные ученые Германии, Франции и Великобритании и бедные и многочисленные ученые России.

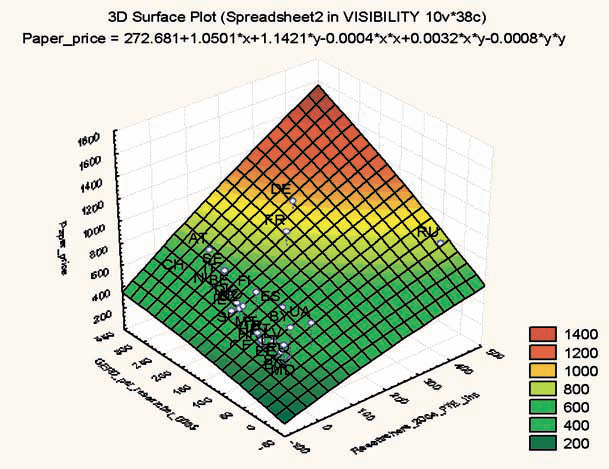

Как это распределение связано с ценой статьи? Рис. 3 показывает, как выглядит связь, аппроксимируемая квадратическими функциями [ 5] (самым значимым отклонением является крошечный и сверхбогатый Люксембург, который был убран с иллюстрации). В целом кажется, что и размер, и объем финансирования в пересчете на одного исследователя имеют убывающую полезность: и самые многочисленные, и самые обеспеченные науки демонстрируют некоторое замедление прироста продуктивности на дополнительную человеческую/финансовую единицу.

Германия, Франция, Великобритания и Россия по этим параметрам находятся в зоне «дорогой» науки. Почему это так? Тут возможно несколько ответов, один из которых указывает на внутренний дефект статистики: НИОКР суммирует разные статьи расходов на исследования, включающие, например, оборонную науку, результаты которой объяснимым образом мало отражены в открытых публикациях и которая при этом дорого стоит [6]. Меньшие страны, в политическом и военном плане следующие за супердержавами, выигрывают за счет этого в интеллектуальной видимости. Так это или нет, но В&М обошли обсуждение этого вопроса вовсе, исключив из рассмотрения все национальные науки, уступающие по размерам итальянской. Сделай они иначе, им пришлось бы отвечать на вопрос: «а что было бы с публикационной отдачей на доллар, если бы численность ученых была сокращена, а финансирование на каждого из них, соответственно, увеличено?» [7].

Опираясь на приведенные здесь данные, можно предположить, что оптимум был бы достигнут при нынешнем уровне финансирования при сокращении численности ученых с 476,5 тыс. (в 2004 г.) до 275 тыс. и соответствующем увеличении финансирования с 37 290 до 64 771 ППС долларов в год. Цена одной статьи в этом случае составила бы порядка 460 тыс. (против нынешних 780 тыс.). Оговорюсь, что лично я против того, чтобы наукометрические данные становились аргументами в пользу проведения каких-то реформ в науке. Уже из этого текста должно быть хорошо понятно, насколько они условны. Если российское правительство купит корпорацию Thomson Scientific, которой принадлежит Web of Science, а затем интегрирует ее с РИНЦем, то публикационные показатели отечественных ученых вырастут в разы. Но всем, кто берется использовать индексы цитирования в их нынешней форме для дачи практических рекомендаций — как В&М, — следует оговаривать любые возможные выводы, а не только те, которые получаются в результате наиболее выигрышных для их политической линии сравнений.

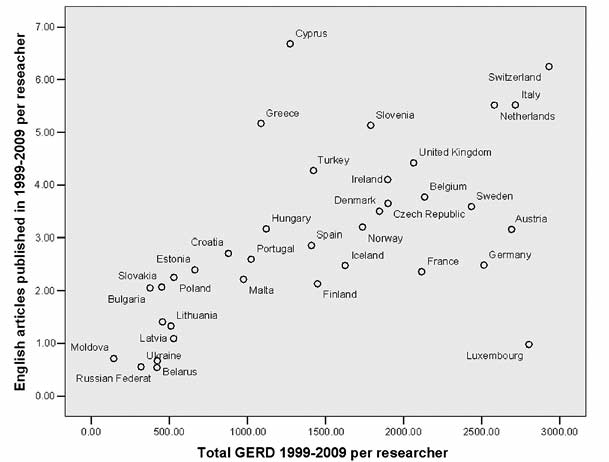

Тем не менее, даже на таком фоне Россия выглядела все еще не слишком хорошо. Рис. 4 показывает соотношение финансирования на одного исследователя и его/ее англоязычной публикационной активности за 1999-2009 гг. Российские ученые ощутимо проигрывали своим примерно столь же бедным коллегам из Болгарии, Словакии, Румынии и Литвы. Вторым ходом в кампании по спасению честного имени российской науки было выделение в особую строчку РАН. Этот шаг в высшей степени спорен сам по себе. Ученые в фундаментальных областях науки пишут больше, чем их занятые в прикладных областях коллеги, а РАН последние полвека безусловно мыслилась как Министерство фундаментальной науки. Сравнение тут сродни сравнению числа сбитых самолетов для двух армий, для одной из которых статистика приводится по летчикам-истребителям, а для другой — по всему персоналу ВВС, включая обслугу аэродромов и штабных офицеров. Видимо, ощущая некоторую шаткость этих построений, В&М выбирают в качестве дополнительного объекта для сравнения французский CNRS как «очень близкое РАН по структуре» учреждение. Сравнения для них приведены в таблице 2: на этот раз, данные взяты из того же источника, что и у В&М, — из Web of Science. Для полноты картины добавлено также два университета, традиционно лидирующих в международных рейтингах, — Гарвард и Кэмбридж.

Таблица 1

|

|

Число иссле- дователей в FTE эквиваленте (2004) |

Число статей в базе Scopus, 1999-2009 | Опубли- кованных статей на исследо- вателя, 1999-2009 | Финансиро- вание иссле- дований и разработок, 000 PPP$ (2004) | Финансирова- ние исследований и разработок, 000 PPP$ (1999-2009) | Цены одной англоязыч- ной статьи, 000 PPP$ в 1999-2009 гг. |

| Austria | 25955,2 | 81898 | 3,16 | 6011812 | 69847847,97 | 852,86 |

| Belarus | 16267,5 | 10896 | 0,67 | 464728,9 | 6891991,58 | 632,52 |

| Belgium | 32400,4 | 122174 | 3,77 | 6035656 | 69165182,96 | 566,12 |

| Bulgaria | 9827 | 20166 | 2,05 | 329746,5 | 3710292,08 | 183,99 |

| Croatia | 7140 | 19342 | 2,71 | 658124,4 | 6274917,26 | 324,42 |

| Cyprus | 583 | 3895 | 6,68 | 63809,62 | 742661,24 | 190,67 |

| CzechRep | 16300 | 59487 | 3,65 | 2458347 | 30975978,44 | 520,72 |

| Denmark | 26166,9 | 91595 | 3,5 | 4341163 | 48297728,39 | 527,30 |

| Estonia | 3369 | 8070 | 2,4 | 170441,5 | 2238549,76 | 277,39 |

| Finland | 41003,5 | 87423 | 2,13 | 5394159 | 59433653,19 | 679,84 |

| France | 202377 | 477820 | 2,36 | 38024854 | 428146826,30 | 896,04 |

| Germany | 270215 | 672079 | 2,49 | 61393169 | 679487593,50 | 1011,02 |

| Greece | 15631,3 | 80787 | 5,17 | 1470640 | 17002950,79 | 210,47 |

| Hungary | 14904 | 47186 | 3,17 | 1439194 | 16708058,82 | 354,09 |

| Iceland | 1917 | 4752 | 2,48 | 3116902,53 | 655,91 | |

| Ireland | 11010 | 45159 | 4,1 | 1831938 | 20898764,73 | 462,78 |

| Italy | 72012,1 | 397427 | 5,52 | 6424866 | 195550505,70 | 492,04 |

| Latvia | 3324 | 3627 | 1,09 | 111509,3 | 1756913,06 | 484,40 |

| Lithuania | 7356 | 9781 | 1,33 | 326601 | 3761169,58 | 384,54 |

| Luxembourg | 2030,8 | 1988 | 0,98 | 485884,7 | 5691149,01 | 2862,75 |

| Malta | 436 | 966 | 2,22 | 41623,17 | 425435,68 | 440,41 |

| Moldova | 2725 | 1937 | 0,71 | 26760,62 | 394787,39 | 203,81 |

| Netherlands | 41543,4 | 229141 | 5,52 | 9642998 | 107236549,40 | 467,99 |

| Norway | 21163 | 67727 | 3,2 | 3093576 | 36769037,77 | 542,90 |

| Poland | 60944 | 137291 | 2,25 | 2773599 | 32286363,32 | 235,17 |

| Portugal | 20684,1 | 53730 | 2,6 | 1552672 | 21189153,41 | 394,36 |

| Romania | 21257 | 29934 | 1,41 | 730839,1 | 9717228,56 | 324,62 |

| RussianFed | 477647 | 258351 | 0,54 | 17811949 | 201534979,40 | 780,08 |

| Slovakia | 10717,8 | 22176 | 2,07 | 404335,1 | 4843574,55 | 218,42 |

| Slovenia | 4030 | 20689 | 5,13 | 608814,3 | 7212709,35 | 348,63 |

| Spain | 100994 | 288791 | 2,86 | 11799537 | 142466262,00 | 493,32 |

| Sweden | 48784 | 175126 | 3,59 | 10462696 | 118754618,90 | 678,11 |

| Switzerland | 25400 | 158725 | 6,25 | 7479222 | 74446595,59 | 469,03 |

| Turkey | 33876 | 144801 | 4,27 | 3572713 | 48214566,78 | 332,97 |

| Ukraine | 81833,6 | 45370 | 0,55 | 2688364 | 26158191,49 | 576,55 |

| United Kingdom | 176040 | 777979 | 4,42 | 32056900 | 363398353,10 | 467,11 |

Как и следовало ожидать, РАН выглядит существенно лучше по числу публикаций на одну ученую голову, чем российская наука в целом. Насчитывая в своих рядах порядка 12% от общего числа исследователей, ее сотрудники фигурируют соавторами в примерно половине статей, причем эта доля выросла с 36 % в 1996 г. до 62 % к настоящему времени [8]. Принимая среднюю численность ученых в РАН за этот период в 55 тысяч, мы получим, например, 0,26 англоязычные статьи в 2005 г. Это даже несколько больше, чем дают В&М как среднее за предыдущее десятилетие, что вполне правдоподобно в свете общего роста числа публикаций в базах. Здесь наши выкладки совпадают.

Далее, однако, показания расходятся. Надо сказать, сравнение с CNRS вообще очень проблематично. Сходство последнего с РАН является в значительной степени мнимым. Короткого визита на сайт CNRS [12] достаточно, чтобы обнаружить масштабные различия. Исследовательский персонал CNRS рассредоточен по 10 институтам и 1074 лабораториям, из которых 90 % находится вне его собственной административной структуры — в университетах, на предприятиях и т.д. — и которые часто финансируются совместно с соответствующими организациями. В некотором смысле CNRS больше похоже на огромный фонд, прямо или косвенно поддерживающий массу людей и институций, непосредственно к нему не относящихся. Сравнение цены одной публикации его сотрудника с ценой публикации сотрудника РАН, которое предпринимают В&М, поэтому заведомо бессмысленно: персонал РАН вначале получает бюджет РАН, а затем — то, что отдельные сотрудники Академии могут заработать на стороне (гранты РФФИ, контракты Минобрнауки и т.д.), но значительная часть бюджета CNRS уходит за его пределы.

Вообще вычленение публикаций сотрудников CNRS, видимо, крайне затруднительно: многие, к неудовольствию руководства Центра, забывают указывать в почтовом адресе факт своей принадлежности к таковому, ограничиваясь просто названием соответствующего университета и департамента [13]. Так или иначе, взяв те публикации за прошедший год, авторы которых ничего не забыли, и поделив их на число исследователей CNRS с сайта (19 100), мы получим 1,08 публикаций в год (1,05 англоязычных) [14]. Это существенно больше тех 3,85 в десятилетие, о которых пишут В&М. Я должен признать, что у меня нет данных о численности персонала CNRS в 19962005 гг. Но для того, чтобы цифры В&М соответствовали действительности, нужно, чтобы при данном количестве публикаций они сократились между 1996-2005 гг. и нынешним моментом как минимум в 2 раза. Насколько мне известно, никаких сокращений такого драматического масштаба во Франции не имело места. Поскольку здесь, как и в других местах, нет ни цифр, исходя из которых В&М производили свои калькуляции, ни указаний на источник этих цифр, я не могу никак прокомментировать происхождение наших разночтений.

Таблица 2

|

|

1996 | 2000 | 2005 | 15.09.09 —

14.09.10 [ 9] |

| РАН [10] | 11655 (8570) | 13468 (12169) | 14116 (13540) | 10946 (10630) |

| Россия в целом [11] | 32335 (22848) | 32627 (28823) | 31001 (29097) | 17469 (16459) |

| CNRS | 18598 (17058) | 19401 (18280) | 23679 (22877) | 20673 (20090) |

| Франция в целом | 58830 (48440) | 63959 (54593) | 73162 (65317) | 55013 (48993) |

| Гарвард | 11131 (11097) | 12174 (12122) | 15571 (15508) | 12664 (12639) |

| Кэмбридж | 16070 (16015) | 17923 (17863) | 20592 (20525) |

15273 (15226) |

Сравнение с Гарвардом или Кембриджем еще менее благоприятно для РАН. Гарвард, например, как извещает раздел статистики на его сайте, насчитывает в 2010/11 уч. году 2100 преподавателей, еще 10 000 состоят исследователями в университетских клиниках. Даже по неполным данным истекшего года, на каждого из них приходится более чем по одной статье (точная цифра, видимо, должна составлять порядка 1,3). Соблазнительно назвать виной всему язык, который ставит англо-американских исследователей в заведомо более выигрышное положение. Многие исследования продемонстрировали, однако, удивительную вещь: англоязычные страны не являются обязательно странами с самыми продуктивными исследователями. Возвращаясь к рис. 4, Великобритания занимает скромное 7-е место в рейтинге публикационной активности (4,42 статьи за 1999-2009 гг.), уступая Кипру (6,68), который, правда, является миниатюрным государством с колониальной историей, Швейцарии (6,25), Италии (5,52), Нидерландам (5,52), Греции (5,17), и постсоциалистической Словении (5,13). Ирландия — на 9-м месте (4,10), пропуская перед собой Турцию (4,27). Франция (2,36) находится на 23-м месте, ниже постсоветской Эстонии (22-я строчка, 2,40), так что ее опережение по этому параметру, вообще говоря, является сомнительным поводом для гордости. Преимущество Гарварда и Кембриджа заключается не только в том, что они расположены в странах, говорящих на языке Мильтона и Шекспира. Но, ограничиваясь сравнением с якобы «очень близким» CNRS, В&М проделывают опять тот же трюк: выбирают предмет для сравнения, рядом с которым будут смотреться выигрышно. Это сравнение снимает еще один неудобный вопрос, на который иначе пришлось бы отвечать: а является ли государственная система институтов вообще такой уж эффективной? В конце концов в России одна Академия наук, а в США есть еще по крайней мере 7-8 университетов, которые могут составить Гарварду конкуренцию.

Итак, вторым ходом В&М неким не совсем понятным путем сократили разрыв между РАН и выбранным ими как объект преследования CNRS. Разрыв, тем не менее, остался значительным, даже по их данным составляя 2,00 статьи на исследователя в год для РАН и 3,85 — для CNRS. И тогда они задействовали последний резерв — пересчитали официальную статистику науки. Здесь надо сделать отступление. Полки книг написаны об условности официальной статистики. Отношение большинства социологов к ней таково, что она появляется в их книгах не иначе как с оговоркой «мы знаем, что это все неправда, но тем не менее…». Однако для людей, которые начали в нее играть, заявить в середине партии, что они ей не доверяют, — это примерно то же, что в ситуации шаха подвергнуть сомнению право слона противника ходить по диагонали. Откажитесь признавать правила — и игра рассыплется. Но именно это и делают В&М. Они указывают при этом на действительно существующую аномалию. Популяцию ученых можно считать по двум показателям — или по абсолютному числу индивидов, которые занимают какую-то исследовательскую позицию, или по числу позиций (FTE-эквивалент). Понятно, что их соотношение вариабельно: кто-то работает на часть ставки, кто-то совмещает несколько. Во всех европейских странах, кроме России, число ставок меньше, чем число индивидов. Так, в 2004 г. в Болгарии оно было 0,87, в Венгрии — 0,86, в Люксембурге — 0,83, во Франции — 0,82, в Румынии — 0,78 — и так до Кипра, Венгрии и Турции, где оно составляло порядка 0,46. В России оно в тот же момент достигало в официальной статистике 1,13. Столкнувшись с этой загадкой, В&М произвели следующую операцию: они вычислили «коэффициент полной занятости для стран с переходной экономикой», составивший 0,58, и пересчитали численность ученых в FTE-эквиваленте на его основании, создав виртуальную науку, численно почти в полтора с лишним раза меньше существующей в правительственных источниках. Напрашивающийся здесь вопрос — почему мы думаем, что государственные статистические органы лучше знают, сколько людей по факту работают в институтах, чем сколько в этих институтах ставок, и почему мы считаем примененную авторами процедуру более корректной, чем прямо противоположную — увеличить число людей, оставив число ставок в неприкосновенности, — остается в тексте В&М без ответа [15]. Судя по тому, что в их списке практических рекомендаций «для оценки показателей результативности академического сектора науки России необходимо использовать разработанную в ЦЭМИ РАН методологию оценки» стоит пунктом первым, В&М считают этот коэффициент своим основным вкладом в сохранение отечественной науки. Его использование позволяет сократить разрыв: разделив имеющиеся публикации на поголовье своих виртуальных ученых, они обнаруживают, что те публикуются почти так же энергично, как их коллеги из CRNS.

Циник мог бы сказать, правда, что виртуальное финансирование на этих виртуальных ученых также почти в два раза больше того, о котором нам сообщает официальная статистика, приближаясь к уровню если не Франции, то Португалии. Какие ученые, такие и зарплаты. Все честно.

Михаил Соколов,

старший научный сотрудник

Лаборатории социологии образования и науки,

доцент факультета политических наук и социологии

Европейского университета в Санкт-Петербурге

1. Ю.Попков, Г.Осипов. Мифы и реалии РАН. «Полит.ру» 27.08.2010 (www.polit.ru/analytics/2010/08/27/ran.html)

2. А.Варшавский, В.Маркусова. Оценку эффективности российских фундаментальных учёных следует скорректировать. «Наука и технологии РФ» 11.01.2009 (www.strf.ru/organization.aspx?CatalogId=221&d_no=17296)

3. Данные были получены в рамках другого проекта (полный отчет о нем – www.cogita.ru/dokumenty/Sokolov_Diaspora.pdf), поэтому важно оговорить, в каких отношениях они были отличны от использовавшихся В&М. Основных отличий было три: (1) использовался Scopus, а не Web of Science; (2) брались 1999-2009 гг., а не 1996-2005; (3) охвачены были все европейские страны, кроме микрогосударств (Сан-Марино, Андорра, Лихтенштейн). Хотя между двумя библиометрическими базами данных имеются ощутимые различия, легко показать, что ни одно из них не особенно существенно для целей сравнения, предпринятого в наших с В&М исследованиях. Аналогично, сдвиг на 3 года мало изменил общие тенденции. Однако выбор между европейскими странами и крупнейшими по численности национальными науками, которые использовали В&М, как мы увидим далее, уже далеко не столь безобиден. Менее важное отличие — В&М считали, видимо, все публикации в базе, я — только тексты на английском языке. Однако поскольку англоязычные статьи составляют более 95 % всех представленных в любом из индексов (см. цифры далее, таблица 2 для WS), эта разница в стратегии не могла дать существенных расхождений в результатах. Наконец, я брал только тексты, квалифицируемые как статьи, — сообщение В&М не упоминает, что в точности считали они. Все статистические данные о финансировании и численности ученых взяты из базы ЮНЕСКО (www.uis.unesco.org/evphp?ID=2867_201&ID2=DO_TOPIC). В тех случаях, когда информация по отдельному году отсутствовала (примерно 10% ячеек по избранным странам для периода 1999-2007 гг.), брались данные по ближайшему наличному году. Данные по 2008 и 2009 гг., статистика по которым пока не представлена, экстраполированы исходя из данных предыдущего десятилетия для всех 36 стран.

4. Тут надо сделать оговорку в отношении одной необъяснимой детали работы В&М. В получившей едва ли не наибольшую известность своей таблице они делят количество публикаций за 10 лет на финансирование за один 2004 г Почему надо было делать именно так, хотя данные о финансировании с 1996 по 1998 г. доступны в том же источнике в относительно полном объеме и можно было получить куда более точную оценку, остается неясным. Конспирологическая версия состоит в нежелании признаваться, что одна статья обходится налогоплательщикам в сотни тысяч долларов. Более реалистическая — в том, что авторы поленились сложить 10 цифр и решили ограничиться одной. В подписи к таблице 3 в их отчете присутствует туманная фраза об отношении «количества статей в 1996—2005 годах на миллион долларов затрат на НИОКР, 2004 г. по ППС», но заключенное в ней предупреждение, однако, повсеместно теряется при цитировании. У использующих их данные Попкова и Осипова [1] речь уже идет об абсолютной цене, а не об условном показателе. В&М ничего не сделали для того, чтобы предотвратить эту естественную ошибку.

5. Это, разумеется, очень приблизительные выкладки, учитывая размер выборки, ненезависимость случаев в ней и ненормальность распределения (для компенсации последнего, впрочем, производились различные пересчеты, дававшие сходные результаты).

6. Соображение предложено автору Маратом Овчинниковым (КГУ) в личном сообщении.

7. Это — один из вечных больных вопросов российской науки. В записке П.Л.Капицы 1935 г. «О науке и ее организации в СССР» мы, например, находим следующее: «Если мы таким образом сократим до одной трети кадровый состав институтов, сохранив те же расходы на научные работы по бюджету, [то] валовая ценность продукции нашей научной сети, которая сейчас исключительно низка (ниже, чем в передовых капиталистических странах, при числе научных работников, превышающем число научных работников всех стран вместе взятых), значительно возрастет». В момент, когда были написаны эти строки, в Академии наук СССР было 25 институтов…

8. Тут есть несколько тонкостей, о которых В&М благоразумно умалчивают. Например, о том, как считались соавторства для авторов из разных институций или для статей, опубликованных в соавторстве с учеными из других стран.

9. Опция «year to date», некоторое уменьшение числа публикаций по всем строкам, скорее всего, результат запозданий в пополнении базы.

10. Суммарные результаты поиска по запросам «Russian Academy of Sciences», «Russian Acad Sci» и «RAS».

11. Суммарные результаты поиска по запросам «Russia» и «Russian Federation».

12. www.cnrs.fr

13. Web of Science не содержит информации об аффилиации авторов — только об их почтовом адресе. Это, разумеется, составляет проблему и для РАН тоже, поскольку некоторые не упоминают, к какой организации относится их институт, а кодировщики WS вводят все, как видят. В этом смысле рекомендация руководству российской науки укрепить корпоративную лояльность своих сотрудников, которую дают В&М, не лишена смысла.

14. На сайте CNRS названо число 33 300, из которых 25 700 tenured. Среди последних 11500 исследователей и 14 200 вспомогательного персонала, а прочие — докторанты, приглашенные исследователи и т.д. Я исключил вспомогательный персонал из числа возможных авторов. Отметим еще раз, что данные по этому году в данный момент еще занижены.

15. В тексте имеются две ссылки на их малодоступные работы, которые, впрочем, судя по оглавлению и введению, выложенным в Интернете, также не содержат какого-то эмпирического разбора гримас официальной статистики.