Как известно, в ноябре 2009 г. Президент РФ дал поручение министру образования и науки Андрею Фурсенко и министру экономического развития и торговли Эльвире Набиуллиной до 1 февраля 2010 г. представить предложения по использованию индекса цитирования для оценки эффективности работы ученых. В предлагаемом ниже материале Михаил Гельфанд, Евгений Онищенко и Сергей Попов рассуждают о том, как и в каких случаях разумно применять разные библиометрические критерии.

Неоднократно обсуждалось, в том числе и в «Троицком варианте», что в российской ситуации, когда организовать полноценную научную экспертизу зачастую достаточно сложно, в качестве временного средства можно использовать формальные критерии. Действительно, в настоящее время никакие научные регалии (вплоть до докторских степеней и членства в Академии наук) не гарантируют высокого научного уровня потенциального эксперта: докторами наук порой становятся люди без публикаций в нормальных рецензируемых журналах, а в члены РАН иногда избираются (даже в области естественных наук!) ученые, чей индекс цитирования не превышает 20. Если в ряде научных направлений еще сохраняются дееспособные сообщества, то во многих других направлениях специалистов мирового уровня очень мало, а то и вовсе нет. При этом внешние признаки научной активности – статьи, диссертации, монографии – вполне могут наличествовать.

В таких условиях библиометрические показатели (в частности, индекс цитирования – citation index), извлекаемые из общепризнанных международных баз данных, являются мощным инструментом при экспертной оценке работы отдельных ученых и научных коллективов, в первую очередь для естественных наук. Они позволяют также независимо контролировать результаты экспертизы. Однако следует понимать, что эффективное применение этого инструмента требует как тщательно разработанных процедур и регламента, так и учета мнения квалифицированных специалистов.

Особенно важно это для России. Опыт последних лет показывает, что в сфере науки в России даже правильные идеи иногда воплощаются в жизнь половинчато и бессистемно, что снижает эффективность принимаемых мер и дискредитирует идею разумных реформ, которые на самом деле остро необходимы. Ярким примером такого «государственного» подхода является реализация ФЦП «Научные и научно-педагогические кадры инновационной России». В условиях существующей нормативной базы (в первую очередь – непригодного для регулирования научных конкурсов Федерального закона 94-ФЗ) и неспособности государственных заказчиков Программы разработать удобный для заявителя и эксперта комплект конкурсных документов не удалось обеспечить поддержку именно лучших научных групп и отдельных молодых исследователей. Об этом также неоднократно писалось на страницах ТрВ-Наука, см., например, [1].

Применение библиометрических показателей требует специфической осторожности. Кажущаяся простота численных индикаторов в комбинации со слабостью системы научной экспертизы в России создает искушение полностью заменить библиометрией экспертную оценку. Свести оценку результативности научной работы к одному – «международно признанному» – числу, что может быть проще и удобнее для чиновника? Как показывают исследования ряда специалистов в странах, где такая тенденция сильна [2], это неправильный подход. Библиометрические показатели должны использоваться не столько сами по себе, сколько в качестве элемента экспертной оценки: индекс цитирования – хороший слуга, но плохой хозяин. Кроме того, следует учитывать особенности структуры цитирований в различных областях науки, что часто проще делать в «ручном режиме».

Ключевым моментом для выработки разумных правил использования библиометрических показателей является отход от стандартной чиновничьей практики выработки решений. Для разработки методических основ и регламентов применения библиометрических показателей следует создать рабочие группы с существенным представительством ведущих ученых из разных областей науки, в том числе имеющих опыт работы за рубежом. Проекты должны пройти общественное обсуждение, причем не только на специально подобранных круглых столах, но и в научной периодике, в профильных научных сообществах, на форумах и т.д.

Нам кажется, что в качестве отправного пункта для обсуждений можно было бы использовать следующие соображения.

Во-первых, необходимо использование всей совокупности библиометрических показателей: индекса цитирования, числа публикаций в зависимости от импакт-фактора журнала, индекса Хирша и т.д. Некорректно сводить научную репутацию к одному числу.

Во-вторых, эксперт должен быть обеспечен не только суммарными и интегрированными показателями, но и доступом к исходным данным о цитировании, т.е. к ведущим мировым базам данных (Web of Science, Scopus). В качестве дополнительных источников, специально оговаривая и мотивируя это, можно использовать другие базы, особенно открытые, в частности базу AMS в математике, NASA ADS – в астрономии, SPIRES SLAC – в физике высоких энергий, PubMed – в биологии и медицине. Использование базы РИНЦ (Российский индекс научного цитирования) в настоящий момент недопустимо, поскольку она неполна и составлена несистематическим образом. Как показывает выборочный анализ по отдельным институтам и авторам, в этой базе данных могут отсутствовать наиболее цитируемые статьи, даже опубликованные в отечественных журналах [3]. Встречаются вопиющие различия в данных о российских ученых в РИНЦ и базами Scopus и Web of Science, когда цитирование российских ученых в РИНЦ занижено (иногда в сотни раз!). Эти же данные должны быть общедоступны для мониторинга экспертизы и ее контроля.

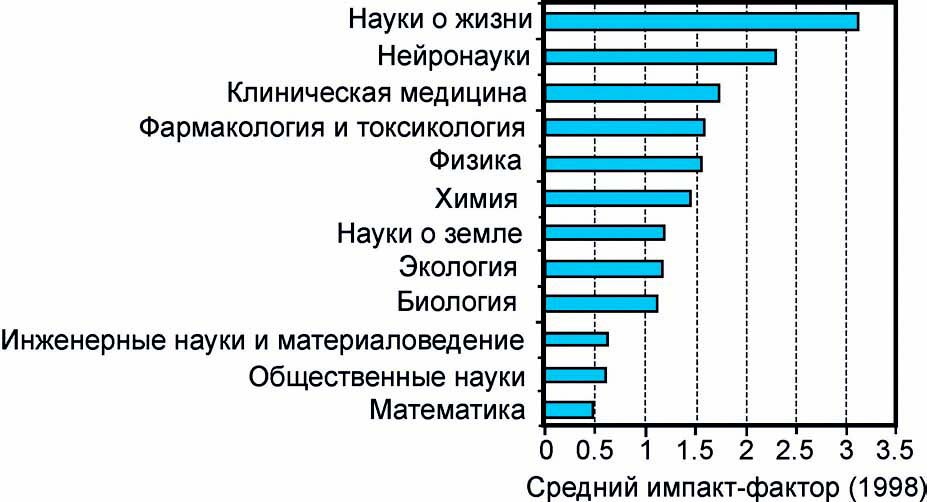

В-третьих, при любых формальных способах оценки библиометрических показателей необходимо учитывать различия в традициях цитирования в разных науках, а часто и в разных разделах одной науки.

В-четвертых, в регламентах экспертизы следует предусмотреть требование к эксперту явно обосновывать случаи существенного расхождения выставляемых оценок с библиометрическими показателями.

Выделим ситуации, в которых, на наш взгляд, наиболее целесообразно применять библиометрические показатели:

1) в качестве квалификационного требования к экспертам научных проектов в интересах научных фондов, государственных программ и учреждений и т.п.;

2) при формулировании минимальных аттестационных требований к сотрудникам научных и образовательных учреждений, научным руководителям дипломников и аспирантов и т.п. (см. [4]);

3) при сравнении отдельных ученых или небольших групп, работающих в одной области;

4) для выделения наиболее активных групп, работающих на мировом уровне (путем сравнения показателей с аналогичными зарубежными группами).

При экспертном анализе эффективности работы крупных установок и центров коллективного пользования следует учитывать цитируемость полученных на них результатов в области фундаментальных исследований и, по мере возможности, проводить сравнение с аналогичными установками в мире.

Напротив, библиометрические критерии плохо подходят для:

1) сравнения результативности ученых, работающих в различных областях науки;

2) сравнения институтов и университетов в целом;

3) определения важности и «приоритетности» отдельных областей знания;

4) сравнения результативности молодых и более опытных ученых без учета времени работы в науке и изменения в традиции цитирования со временем.

Не следует придавать значения несущественным количественным различиям в библиометрических показателях. Интересно, что именно этот пункт активно обсуждается в известном отчете математиков и дискуссии вокруг отчета [2]. Там зачастую речь идет о 30-50%-ных различиях. В то же время в России чаще всего речь идет об отличии в десятки раз по индексу цитирования или в разы в импакт-факторе журналов; т.е. многие из обсуждаемых в мировой литературе доводов критиков не имеют отношения к российской ситуации. При оценке к данным следует применять сглаживающие процедуры.

Отдельно отметим, что показатели, основанные на цитируемости, малопригодны для оценки успешности текущей научной работы. В этом случае можно использовать число публикаций с учетом импакт-фактора журнала, количества соавторов, позиции в списке авторов и т.п.

При использовании индикаторов важно различать, с какой целью проводится экспертиза:

1) премирование,

2) стимулирование,

3) оценка будущей продуктивности,

4) оценка способности выполнить конкретную задачу.

Разные задачи эффективно решаются с использованием разных критериев. В частности, для премирования целесообразно использовать суммарные показатели за большие периоды времени, для стимулирования – показатели, отражающие текущую активность, для оценки будущей продуктивности – комбинацию этих показателей, отражающую динамику публикационной активности. Конкретный набор применяемых критериев и методика работы с ними в каждом конкретном случае должны тщательно обсуждаться с участием активно работающих ученых и после этого включаться в регламенты экспертизы.

Как показывает практика реализации систем выплаты стимулирующих надбавок на основании наукометрических показателей внутри научных и образовательных учреждений (например, надбавки по ПРНД в РАН), в силу как объективных, так и субъективных причин внутриучрежденческие системы выплаты надбавок не способны обеспечить качественное и единообразное проведение разумной государственной политики. В то же время в мире имеются примеры эффективно работающих общегосударственных открытых систем стимулирующих выплат (фактически систем выдачи индивидуальных грантов на основании в первую очередь публикационных показателей). В связи с этим одной из возможностей может быть создание открытой общегосударственной системы выплаты стимулирующих надбавок, основанной на заявительном принципе, которая облегчит в свою очередь переход к новой кадровой системе в науке и образовании (см. [4]).

В заключение следует подчеркнуть, что разумное применение формальных критериев для первичного отбора экспертов, проведения некоторых описанных выше видов экспертизы, а также для контроля результатов оценки способно в итоге существенно повысить уровень развития науки в нашей стране. Для проведения качественной экспертизы кроме адекватного использования формальных критериев требуется модернизация механизма принятия решений. Для этого необходимо выработать действенные, а не формальные механизмы учета мнения научного сообщества при принятии решений, и следует в обязательном порядке привлекать к работе над концептуальными документами и регламентами ученых, работающих на мировом уровне и потому лучше других понимающих специфику работы в своей области науки.

Авторы благодарят за обсуждение Дмитрия Горбунова, Егора Задереева, Алексея Иванова.

Примечания

[1] «ФЦП «Кадры» – гладко было на бумаге» «Троицкий вариант» от 27 октября 2009 г. www.scientific.ru/journal/news/2009/1009/kadry3.html [2] Доклад Международного математического союза совместно с Международным советом по промышленной и прикладной математике и Институтом математической статистики. http://arxiv.org/abs/0910.3529 [3] Так, например, цитируемость нобелевского лауреата Жореса Алферова, согласно Web of Science, в 38 раз выше, чем по данным РИНЦ. [4] Доклад Координационного Совета по делам молодежи в научной и образовательной сферах при СНТО за 2007 г «Актуальные задачи воспроизводства кадров в научно-образовательной сфере и пути их решения» – www.youngscience.ru/753/821/981/index.shtml